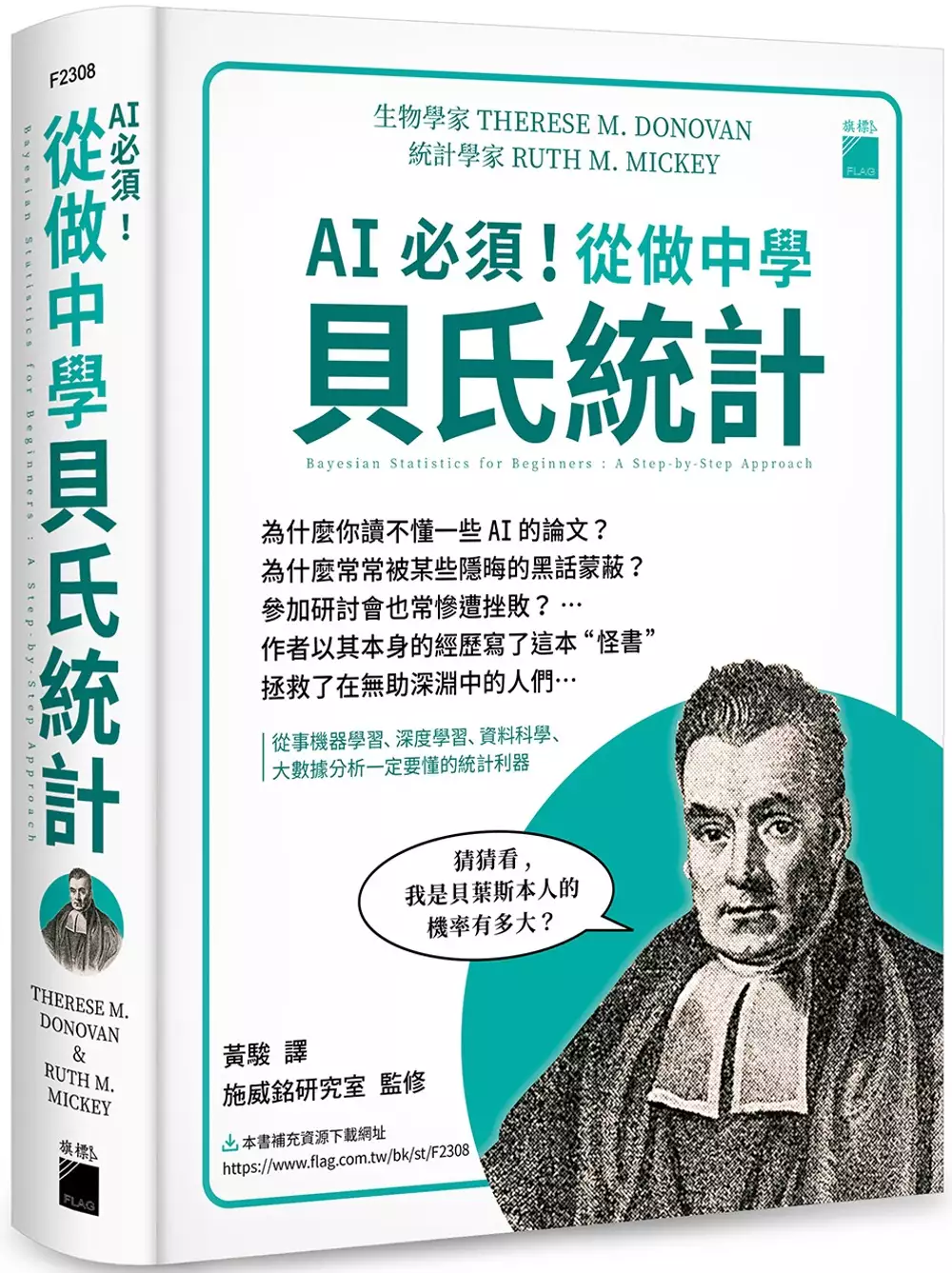

beta翻譯的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦ThereseDonovan,RuthMickey寫的 AI 必須!從做中學貝氏統計:從事機器學習、深度學習、資料科學、大數據分析一定要懂的統計利器 和SethStephens-Davidowitz的 數據、真相與人生:前Google資料科學家用大數據,找出致富、職涯與婚姻的人生解答都 可以從中找到所需的評價。

另外網站【beta】什么意思_英語beta的翻譯_音標_讀音_用法 - Fvilb也說明:beta翻譯 (中文英文):貝它, 希臘字母中的…《抓鳥》 … beta 測試版是什么 意思 _百度知道. BETA是什麼意思? – BETA的全稱 ...

這兩本書分別來自旗標 和商周出版所出版 。

國立彰化師範大學 翻譯研究所 曾文培、蔡佩舒所指導 周欣怡的 英進中筆譯及視譯之翻譯品質與腦波研究 (2021),提出beta翻譯關鍵因素是什麼,來自於腦波、翻譯、視譯、翻譯品質、洋蔥句。

而第二篇論文國立陽明交通大學 電信工程研究所 簡仁宗所指導 李尚恩的 對比式解纏記憶於循序學習 (2021),提出因為有 深度學習、序列對序列學習、對比學習、自監督學習、注意力模型、轉換器、語言模型、自然語言處理、機器翻譯、語音辨識、記憶體取代機制的重點而找出了 beta翻譯的解答。

最後網站Solana主網停機事件報告:因大量鑄造機器人湧入所致 - 鏈新聞則補充:對此,Metaplex 未來將推出懲罰機制,若該錢包嘗試完成無效交易,將收取0.01 SOL 罰款。 Today #Solana mainnet-beta went down partially due to botting ...

AI 必須!從做中學貝氏統計:從事機器學習、深度學習、資料科學、大數據分析一定要懂的統計利器

為了解決beta翻譯 的問題,作者ThereseDonovan,RuthMickey 這樣論述:

貝氏統計因 AI 機器學習的發展而再度翻紅,其核心是利用統計推論的方法,在觀測到新證據或取得新資訊時,利用科學方法循環更新先前假設的機率,非常適合只能依據僅有的且不夠完整的資訊進行假設評估的技術。目前廣泛應用於機器學習、深度學習、資料科學、大數據分析等領域。 正經八百的念經書只會讓人想睡覺,而本書很不一樣,作者依其自身的(慘痛)經歷規劃出這本神奇之書,隨時與學習者站在一起,將腦海經常冒出來的疑問,以豐富的圖表、實作輔助並提供許多參考資源的問答方法呈現。對於重要觀念與公式,也用不同顏色標示(對了!本書是彩色書,灑花),不斷的前後呼應提醒,才不會讀到後面卻忘了前面,進而確實掌握貝氏

統計的精髓。本書討論到 MCMC (馬可夫鏈蒙地卡羅法)之處尤其精彩,一般貝氏書籍或網路文章只講理論或舉個簡單例子交代一下就完事了,而本書是實實在在的帶領讀者一遍一遍的演練,落實從做中學的精神。 對於想瞭解貝氏統計的各領域專業人員,包括機器學習、深度學習、生命與醫學、心理學、公共衛生、商業數據分析等,都是淺顯易懂的好書。也適合學習統計、人工智慧相關領域大學高年級與研究所程度的學生。 本書特色 ○由施威銘研究室監修內容,適時補充編註與譯註,幫助讀者確實理解內容。 ○貫徹『講七遍、做二十一遍』的精神,真正從做中學會的就不會忘記。 ○本書厚達六百多頁,為考慮到學習的便利性

與舒適性,採用全彩印刷容易分辨重點、並以軟精裝裝訂可攤平閱讀。 ○額外提供原文書也沒有的書中分佈函數 Python 程式碼下載,可自行修改參數觀察函數圖形變化。

beta翻譯進入發燒排行的影片

From Map maker - Pakaran (原作)

Translate/Upload to TW server - Beta(翻譯/上傳/除錯)

英進中筆譯及視譯之翻譯品質與腦波研究

為了解決beta翻譯 的問題,作者周欣怡 這樣論述:

本研究嘗試探討並區分筆譯和視譯時所產生的腦波訊號,並研究腦波與譯文品質間的關係。此外,本研究也探討翻譯品質與腦波的相關性。筆譯及視譯皆有認知歷程像是閱讀及以口說或手寫(打字)方式產出譯文。因此在實驗設計上,本實驗加入英打、閱讀及朗讀英文文章三種行為作為筆譯與視譯的對照。控制變項為文章難度、字數、及文章主題。研究材料之英文文章皆採自網頁Project Syndicate財經文章。此財經文章多為學者撰寫,學者多習慣用句法較為複雜的洋蔥句敘述,因此也會探討翻譯洋蔥句時的腦波。實驗結果顯示,視譯比起閱讀的delta、high alpha、low alpha、low beta及theta波還要高,筆譯

的low beta 較閱讀高;而視譯與朗讀相比,因為朗讀較專注於發音、咬字,導致控制運動的low gamma、mid gamma 較活耀;筆譯和打字相比,打字的high beta 較高,推測英打較筆譯需要的專注度更高導致;視譯在動作、語言能力、反應、專注都較筆譯來的高,筆譯與視譯相比之下,八個腦波頻段(low alpha, high alpha, low beta, high beta, delta, theta, low gamma, mid gamma)都是視譯較高。從時間來分析,發現僅有視譯明顯會受字數多寡影響,字數越多,花的時間越多;字數越少,花的時間越少:筆譯的時間則是會隨著起頭或結

尾影響,起頭的段落花的時間較短,結尾的段落則花的時間較長。而翻譯品質方面,發現與專注、語言能力及資訊處理相關的high beta、mid gamma 較高時,得分較高;而與意識也有關的low alpha、theta、delta 波則是較低時,得分較高。另一方面,若受試者在視譯的句子花的時間較少,分數較高,推斷若譯者反應佳、語言能力好,在第一時間就決定是否能產出較好的譯文。而在洋蔥句方面沒有發現明顯的差異。此實驗在五種任務之間,發現腦波有顯著差異,在時間方面觀察到筆譯與視譯的差別,也發現某些腦波與時間長短與譯文品質相關,只可惜洋蔥句的設計不足,沒有特別的發現。因此,此實驗發現譯文品質與腦波hig

h beta、mid gamma、low alpha、theta、delta 波相關,在未來教學或訓練中,這些腦波的變化也可以當作判斷譯文品質好壞的依據。

數據、真相與人生:前Google資料科學家用大數據,找出致富、職涯與婚姻的人生解答

為了解決beta翻譯 的問題,作者SethStephens-Davidowitz 這樣論述:

◆《數據、謊言與真相》作者再次重磅出擊!◆ 最會說故事的資料科學家, 用最幽默的語句、最驚奇的發現, 告訴你大數據不只是工作的利器,更是讓人生升級的工具! 我們不只對朋友、對另一半、對主管說謊,甚至也對自己說謊── 前Google資料科學家賽斯‧史蒂芬斯—大衛德維茲, 利用「永不說謊」的大數據,親自為你探索人生的各種重大問題! 從戀愛、婚姻、理財、教養到工作, 真正的成功關鍵,絕對跟我們想像中截然不同! 如果《數據、謊言與真相》用大數據揭露了世界的真相; 本書將用這些真相,教你做出更好的人生決定! ※關於尋找對象的人生解答 ‧交友網站的致勝密碼除了長相好看,居然還包括長相獨特─

─藍色頭髮甚至大光頭! ‧越級打怪的成功率其實沒有想像中低,最缺乏魅力的人越級打怪,至少有15%~35%的機率收到回覆! ‧跟交往長久有正相關的不是身高、職業與外貌,而是成長思維與安全依附! →長相不如人,就盡量讓自己與眾不同;然後把焦點放在對方的內在而非外在素質。 ※關於創業致富的人生解答 ‧財富位居全美0.1%的人中,84%至少有部分收入來自自己的事業! ‧根據稅務大數據,最容易致富的六大產業是──房地產、投資、汽車經銷商、獨立創作公司、市場調查、中盤商,因為它們能夠「規避價格競爭」! ‧別被聳動報導騙了!資深圈內人自立門戶,才是創業成功率最高的一群。 →選擇對的領域創業,再加上在專精

領域的足夠優勢,就能大幅提升職涯成功率。 ※關於教養子女的人生解答 ‧在健康狀況、未來收入、教育程度……等方面,父母對子女的影響都出奇地小! ‧孟母三遷是對的?!選對小孩的成長環境,就能讓孩子的未來收入成長12%! →你讓孩子接觸到哪些人,比起為他做的任何決定,更可能改變他的一生。 從提升幸福感到掌握致富關鍵,你的直覺可能都是錯的! 本書將告訴你如何用數據找出成功索引,靠數據覓得人生解答!

對比式解纏記憶於循序學習

為了解決beta翻譯 的問題,作者李尚恩 這樣論述:

Chinese Abstract iEnglish Abstract iiiContents vList of Tables viiiList of Figures ixList of Algorithms xiv1 Introduction 11.1 Background Survey . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11.2 Motivation of this Study . . . . . . . . . . . . . . . . . . . . . . . . . 21.3 Outline of Th

esis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42 Sequential Learning 52.1 Introduction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52.1.1 Language Model . . . . . . . . . . . . . . . . . . . . . . . . . 62.2 Recurrent Network . . . . . . . . . . . . . . . . . . .

. . . . . . . . . 82.2.1 Recurrent Neural Network . . . . . . . . . . . . . . . . . . . . 82.2.2 Long Short-Term Memory . . . . . . . . . . . . . . . . . . . . 92.3 Variational Autoencoder . . . . . . . . . . . . . . . . . . . . . . . . . 102.3.1 Autoencoder . . . . . . . . . . . . . . . . . . . .

. . . . . . . . 102.3.2 Variational inference . . . . . . . . . . . . . . . . . . . . . . . 122.3.3 Variational autoencoder . . . . . . . . . . . . . . . . . . . . . 132.4 Transformer . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 152.4.1 Transformer Encoder . . . . . . . . . . . .

. . . . . . . . . . . 222.4.2 Transformer Decoder . . . . . . . . . . . . . . . . . . . . . . . 232.5 Application . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 252.5.1 Machine Translation . . . . . . . . . . . . . . . . . . . . . . . 252.5.2 Question Answering . . . . . . . . . . .

. . . . . . . . . . . . 262.5.3 Speech recognition . . . . . . . . . . . . . . . . . . . . . . . . 263 Efficient Attention for Sequential Learning 273.1 Sparse Attention . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 283.1.1 Special Attention Map . . . . . . . . . . . . . . . . . . . . .

. 283.1.2 Clustering Method . . . . . . . . . . . . . . . . . . . . . . . . 293.1.3 Hierarchical Approach . . . . . . . . . . . . . . . . . . . . . . 303.2 Recurrent Attention . . . . . . . . . . . . . . . . . . . . . . . . . . . 323.2.1 Additional Memory in Attention Mechanism . . . . . . . . . .

323.2.2 Compressive Memory in Attention Mechanism . . . . . . . . . 344 Contrastive Disentangled Memory for Sequential Learning 374.1 Contrastive Self-supervised Learning . . . . . . . . . . . . . . . . . . 374.1.1 Contrastive Learning for visual data . . . . . . . . . . . . . . 394.1.2 Contrastive

Learning for sequential data . . . . . . . . . . . . 414.2 Information Bottleneck . . . . . . . . . . . . . . . . . . . . . . . . . . 424.2.1 Mutual Information . . . . . . . . . . . . . . . . . . . . . . . . 424.2.2 Variational Information Bottleneck . . . . . . . . . . . . . . . 454.2.3 Disentangl

ement in Variational Information Bottleneck . . . . 484.3 Contrastive Disentangled Memory . . . . . . . . . . . . . . . . . . . . 524.3.1 Memory Updated Mechanism . . . . . . . . . . . . . . . . . . 524.3.2 Contrastive Disentangled Memory in Recurrent Neural Network 554.3.3 Contrastive Disentangled

Memory in Transformer . . . . . . . 564.4 Expand to Online Sequence-to-sequence Model . . . . . . . . . . . . . 584.4.1 Transducer . . . . . . . . . . . . . . . . . . . . . . . . . . . . 594.4.2 Beam search . . . . . . . . . . . . . . . . . . . . . . . . . . . . 614.4.3 Language Model Fusion . . . .

. . . . . . . . . . . . . . . . . 664.4.4 On-line Acoustic Model for Speech Recognition . . . . . . . . 695 Experiments 725.1 Machine Translation . . . . . . . . . . . . . . . . . . . . . . . . . . . 725.1.1 Dataset . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 725.1.2 Model Configura

tion . . . . . . . . . . . . . . . . . . . . . . . 725.1.3 Result and Analysis . . . . . . . . . . . . . . . . . . . . . . . . 735.2 Speech Recognition . . . . . . . . . . . . . . . . . . . . . . . . . . . . 765.2.1 Dataset . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 765.2.2 Data Pre

processing . . . . . . . . . . . . . . . . . . . . . . . . 765.2.3 Model Configuration . . . . . . . . . . . . . . . . . . . . . . . 785.2.4 Result and Analysis . . . . . . . . . . . . . . . . . . . . . . . . 786 Conclusion and Future Works 866.1 Conclusions . . . . . . . . . . . . . . . . . . . . .

. . . . . . . . . . . 866.2 Future Works . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 86

beta翻譯的網路口碑排行榜

-

#1.蘋果iOS 14 Beta 翻譯「我覺得iOS 不如安卓」,結果太傲嬌- 壹讀

在WWDC 2020全球開發者大會上,蘋果正式發布了iOS 14系統,並已經推送了iOS 14 Beta 預覽版,首次正式介紹了其最新版的iPhone軟體,它為iOS主屏幕帶來 ... 於 read01.com -

#2.LibreOffice 4.1 Beta 版與中文翻譯相關事務

LibreOffice 4.1 Beta 版剛發布不久,翻譯也正式開跑約一週左右。 官方利用Pootle 平臺代管翻譯,並使用4.0 版的翻譯對4.1 版的翻譯樣板作更新,但 ... 於 libreo-zht.blogspot.com -

#3.【beta】什么意思_英語beta的翻譯_音標_讀音_用法 - Fvilb

beta翻譯 (中文英文):貝它, 希臘字母中的…《抓鳥》 … beta 測試版是什么 意思 _百度知道. BETA是什麼意思? – BETA的全稱 ... 於 www.ussvalkyre.co -

#4.Solana主網停機事件報告:因大量鑄造機器人湧入所致 - 鏈新聞

對此,Metaplex 未來將推出懲罰機制,若該錢包嘗試完成無效交易,將收取0.01 SOL 罰款。 Today #Solana mainnet-beta went down partially due to botting ... 於 www.abmedia.io -

#5.[暴雪] 鬥陣2:PVP BETA測試,掛直播拿資格- c_chat

17 [討論] 神之手翻譯成黃金神掌算超譯嗎? 26 c_chat 2022-04-27 15:42. 於 pttcomic.com -

#6.Google網頁翻譯工具Beta_百度百科

它可以隨時將需要翻譯的內容翻譯為你所需要的語言,但用它翻譯古詩詞卻破壞了古詩詞的美感。 中文名. Google網頁翻譯工具Beta. 軟件大小. 於 baike.baidu.hk -

#7.beta 意思英文

beta 意思英文 ... 英文解釋. the 2nd letter of the Greek alphabet. preliminary or testing stage of a software or hardware product; “a beta version”; “beta software ... 於 www.usaield.me -

#8.聽過渣男、甘蔗男⋯那你知道阿法男、貝塔男是什麼意思嗎?

「Alpha男」跟「Beta男」是源自於一個「紅藥丸理論」,該理論是從電影《駭客任務》中的情節衍伸而來,劇中吃下藍色藥丸可保持無知,活在夢境中,而紅 ... 於 dailyview.tw -

#9.BETA.INV 函數

試用版。INV 會回到Beta 累加機率密度函數的反函數(BETA。DIST) 。 若probability = BETA.DIST(x,...TRUE),則BETA.INV(probability,...) = x。 於 support.microsoft.com -

#10.Β - 维基百科,自由的百科全书

Beta (Βήτα;大寫Β,小寫β,中文音译:贝塔、貝他、啤打,音/'viːta/,英语读法/biːtə/ ),是第二個希臘字母。在古希臘語,beta讀作[b],但現代希臘語讀作[v]。 於 zh.m.wikipedia.org -

#11.Jisho.org: Japanese Dictionary

Powerful and easy-to-use online Japanese dictionary with words, kanji and example sentences. 於 jisho.org -

#12.三星網際網路14.0 Beta版全新登場

翻譯 擴充功能:借助Samsung Research翻譯引擎技術,此擴充功能支援18種語言 (註五) ,供用戶輕鬆檢視網頁上的翻譯內容。 待Beta版測試完成,三星網際 ... 於 news.samsung.com -

#13.歡迎參加《鬥陣特攻2》第一波PvP Beta 測試!

我們會努力為全世界各地的玩家把關,在遊戲正式發行以前打造出全面在地化的翻譯內容和遊戲體驗! 問:如果我有受邀參加PvP Beta 測試,是否能夠實況串流 ... 於 news.blizzard.com -

#14.根本吃了「翻譯蒟蒻」⋯這翻譯軟體超越Google、微軟 - 風傳媒

這也逐漸成為新的翻譯工具DeepL的基礎。 DeepL--深度學習. DeepL是deep learning的縮寫,意思是深度學習。這是人工智能的一個方面,即模仿人類 ... 於 www.storm.mg -

#15.第七史詩賽娜- 3樓貓

【PC遊戲】翻譯萬字!這部童年神作史詩戰爭系列究竟講了什麼? ... 《鬥陣特攻歸來》新版本PVP BETA搶先體驗史詩級更新:計分板推出 ... 於 game.3loumao.org -

#16.台大機械系

高中生園地 · 認識臺大機械系 · 臺大機械系友會 · 古董機構教學網 · 工綜二期捐款芳名錄 · 臺大工學院 · 臺灣大學. 自訂網頁: 訪客數. 訪客人數. 目前線上人數:5 於 www.me.ntu.edu.tw -

#17.Google 翻譯,Gboard Beta 鍵盤上的翻譯| 所有安卓系統

谷歌翻譯,Gboard Beta 鍵盤上的翻譯。 G這個安卓應用程序添加了一個新功能,允許您在編寫文本時執行同聲翻譯。 於 www.todoandroid.es -

#18.耽美小說裡的beta,omega,alpha是啥意思啊 - 迪克知識網

耽美小說裡的beta,omega,alpha是啥意思啊,1樓七斬虛stars空一般有這些詞都是挺黃暴的2樓回騰撒和暖我猜的,大概是這麼個意思。beta是雙性人, ... 於 www.diklearn.com -

#19.翻譯

Google 的免費翻譯服務提供中文和其他上百種語言的互譯功能,能即時翻譯字詞、詞組和網頁內容。 於 translate.google.cn -

#20.標普500高Beta指數

此網站顯示的內容原本為英文,並翻譯成中文以便閱覽。如中/英文翻譯之間存有差異,相關內容則以英文版本為準。標普道瓊斯指數英文網站的網址為www.spglobal.com/spdji/en。 於 www.spglobal.com -

#21.Microsoft SwiftKey Beta - Google Play 應用程式

BETA VERSION - Welcome to the beta program for Microsoft SwiftKey Keyboard - here you can test early performance updates, new unreleased features, ... 於 play.google.com -

#22.beta翻譯 - 軟體兄弟

beta翻譯 :(希臘語字母表的第二個字母), (軟體程式)尚未推出市場,處於第二個開發 ... 同时,该页为英语学习者提供:Beta的中文翻译、英英详解、单词音标、在线 ... 於 softwarebrother.com -

#23.協助改善Google 翻譯品質

你可以向「Google 翻譯貢獻」提交意見回饋,協助其他人進一步瞭解你慣用的語言。 ... 在Google 翻譯首頁上驗證譯文並貢獻一己之力 ... 使用Beta 版模型翻譯文字. 於 support.google.com -

#24.【科技新知】一秒翻譯成中文!iPhone如何使用Safari翻譯網頁 ...

每次用電腦開啟國外網站時,都可以直接將網頁上的語言翻譯成中文,讓我們能大致理解其中的文意;而Apple日前終於也在iOS14版本,新增「Safari網頁 ... 於 www.jyes.com.tw -

#25."alpha,beta"是什麼意思? - 關於英語(美國)的問題| HiNative

alpha,beta的意思alpha "used to describe someone who is strong or powerful, and who likes to be in charge of others: ... 於 tw.hinative.com -

#26.Beta....Beta永遠不變- 凱拉特的翻譯窩 - Facebook

凱拉特的翻譯窩. Sep 11, 2016. Beta....Beta永遠不變. 72. 72. 4. 4. Related Pages. No photo description available. 翻譯: Tony Tsou. Public Figure. 於 www.facebook.com -

#27.beta site - 貝他現場 - 國家教育研究院雙語詞彙

釋義; 翻譯. 回簡目列表 修訂/勘誤建議 單筆輸出. QRCode. 貝他現場. beta site. 2003年6月 資訊與通信術語辭典. 名詞解釋: 一個人或一個組織將所生產軟體公開之前,從 ... 於 terms.naer.edu.tw -

#28.在Mac 上的Safari 中翻譯網頁

若您認為翻譯可能需要改進,請按一下「翻譯」按鈕 ,然後選擇「回報翻譯問題」。該翻譯便會傳送給Apple 檢查。 若語言無法使用. 您可以在「語言與地區」 ... 於 support.apple.com -

#29.YouTube翻譯功能beta版推出 - Meet創業小聚- 數位時代

YouTube網站推出新的翻譯功能,該功能顯示於調整音量鈕右邊的「cc」,可以將聲音變成文字,或將字幕翻譯成其他語言,也可設定照片。現在還是beta ... 於 meet.bnext.com.tw -

#30.無敵CD-865 light 翻譯機說明書

翻譯 結果畫面. 會提供[ 比對精靈],並提供牛津/無敵/擴充句庫的例句參考。 ˙ [ 中文/英文]-- 切換參考例句中文/英文顯示;. ˙ [ 中英對照]-- 逐條瀏覽參考例句的中英文 ... 於 www.besta.com.tw -

#31.翻译

Google 的免费翻译服务可提供简体中文和另外100 多种语言之间的互译功能,可让您即时翻译字词、短语和网页内容。 於 translate.google.com -

#32.beta中文, beta是什麼意思:貝它… - 查查在線詞典

beta 中文::貝它…,點擊查查權威綫上辭典詳細解釋beta的中文翻譯,beta的發音,音標,用法和例句等。 於 tw.ichacha.net -

#33.想了解omega,alpha,ABO是什么意思,别人说的时候我都 ...

哈哈哈哈哈哈哈. ABO是一种人物设定啦。 ABO分别代指alpha、beta、omega。 alpha和omega数量稀缺。alpha通常体质、头脑都很好,是社会中的精英;omega则十分娇弱,但 ... 於 www.zhihu.com -

#34.Beta 2-microglobulin-檢驗項目內容 - 長庚醫院

血清β2-Microglobulin濃度在發炎疾病(如類風濕性關節炎、全身性紅斑性狼瘡、Sjögren's症候群及Crohn's症候群)及淋巴增生疾病(如多發性骨髓瘤、β細胞骨髓瘤及慢性淋巴性 ... 於 www1.cgmh.org.tw -

#35.beta怎么读,beta翻译为:贝塔,希腊字母中的第 - 英语翻译 ...

beta 的中文意思:贝塔,希腊字母中的第,点击查看详细解释:beta的中文翻译、beta的发音、音标、用法和双语例句等,让你有效掌握beta这个单词。 於 fy.tingclass.net -

#36.德文Beta中文翻譯 - 字典

德中字典>> E開頭詞條>>德文Beta是什麼意思Beta Beta的英文解釋Beta的法文解釋Beta漢語翻譯(n) -s 希臘文字的第二個字母(B,β)專業字典【汽車】貝塔猜你喜歡:Mauserei ... 於 www.70thvictory.com.tw -

#37.IT應用系列7:全球網上拍賣.玩BLOG.網路商店賺錢絕技大公開: 低風險.高回報.專家教路.醒你網上賺錢好路數

... 工具( T }說明)上一頁,搜尋我的最愛連結:網址 D Y !, http://mysinablog.com/admin.php?op=blogSelect&blogId=15041 搜尋:移至拍賣,網頁翻譯,信箱 3 Beta sna.c. 於 books.google.com.tw -

#38.用iPhone、iPad 內建Safari 把英文網頁翻譯成中文 - 蘋果仁

如果是第一次使用Safari 翻譯功能的話,會看到以下的提示,告訴你目前Safari 翻譯功能僅是Beta 版本,且翻譯的內容和位置會回傳到Apple 伺服器。 於 applealmond.com -

#39.beta - Linguee | 中英词典(更多其他语言)

大量翻译例句关于"beta" – 英中词典以及8百万条中文译文例句搜索。 於 cn.linguee.com -

#40.新聞翻譯: 原則與方法 - 第 124 頁 - Google 圖書結果

... protocol (HTTP)超文本傳輸協定 portable documentfonnat(PDF)可攜帶文檔格式 uniform resources locator (URL)通用分類位址 Beta version 試用版本 drag-and-drop ... 於 books.google.com.tw -

#41.iOS 15 翻譯功能正式支援繁體中文 - 流動日報

設定繁體中文翻譯. 1:進入Safari,開啟一些英文或日文的外語網站。 2:選取一些要翻譯的字句,然後從選單 ... 於 www.newmobilelife.com -

#42.alpha,beta,gamma hypothesis是什麼意思、英文翻譯及中文解釋

alpha,beta,gamma hypothesis是什麼意思、英文翻譯及中文解釋簡介:alpha,beta,gamma hypothesis詞語: alpha,beta,gamma hypothesis解釋: 學習的三 ... 於 www.yydjb.com -

#43.[App] 你的隨行翻譯員「Google翻譯」大更新!「即時鏡頭翻譯 ...

Google 翻譯更新功能簡介 · Android 4.2、iOS 8.0以上手機,即時鏡頭翻譯(Word Lens)支援中文翻譯即果。 · 一鍵翻譯(Tap to Translate)支援Android 4.2 ... 於 axiang.cc -

#44.Bing Microsoft Translator

Quickly translate words and phrases between English and over 100 languages. 於 www.bing.com -

#45.財報狗-穩健的報酬,更悠閒的生活

財報狗敏銳的嗅覺,1分鐘內幫您嗅出被隱藏的績優股。財報狗提供齊全的關鍵財報數據走勢圖,精準的選股程式,個股新聞訂閱,還有價值投資討論區和社群。 於 statementdog.com -

#46.【思想領袖】無症狀傳播或是疫情中最大謬誤

... 採訪報導/秋生翻譯)「關於疫苗的信息非常之多,但對於(藥物)治療方法, ... 還有一些野生型(病毒)株,總是會有Alpha、Beta、Gamma、Epsilon ... 於 www.epochtimes.com -

#47.beta version 中文意思是什麼

beta : n. 1. 希臘字母第二字[B,β]。2. 第二位的東西。3. 【天文學】β星〈星座中第二等最亮的星〉。 version: n 1 翻譯;譯本,譯文。2 (個人對某事的)說法,不同 ... 於 terryl.in -

#48.蘋果iOS 14 Beta 翻譯「我覺得iOS 不如安卓」,結果太傲嬌

蘋果iOS 14 Beta 翻譯「我覺得iOS 不如安卓」,結果太傲嬌. 2020-12-11 IT之家. IT之家6月24日消息在WWDC 2020全球開發者大會上,蘋果正式發布了iOS 14系統,並已經推送 ... 於 ppfocus.com -

#49.翻译beta的意思- 用法_例句_英语短语 - 沪江网校

beta. 英音: ['beitə] 美音: ['beitə]. 名词 1. 贝塔,希腊字母中的第二个字母 2.(系列中)第二(个) 3. 公测 adj. 【化学】β位的,第二位的 ... 於 www.hujiang.com -

#50.macOS 版Teams Beta 已經發佈,不管M1 Mac 還是 ... - 奇摩新聞

然而到目前為止,macOS 版Microsoft Teams 仍然作為Intel 應用程式在Apple Silicon Macs 上運行,這一度使用Rosetta 2 翻譯技術。 於 tw.sports.yahoo.com -

#51.微軟推出Translator 10 Beta通用版翻譯應用 - 每日頭條

除傳統文本輸入翻譯之外,Translator 10 Beta應用更是允許通過相機來捕捉鏡頭前任何帶有標識、文字等圖像,然後識別這些文字轉換成為數碼格式,並通過內置 ... 於 kknews.cc -

#52.戰地風雲5》Beta測試菜單界面翻譯(攻略 - steamXO

《戰地風雲5》Beta測試菜單界面翻譯(攻略) 《戰地風雲5》Beta測試已經開始了,遊戲界面的很多英文可能有玩家不是很適應,下面爲大家帶來「Hero血 ... 於 www.steamxo.com -

#53.手機週刊: iPhoneS X Android Issue 606 - 第 1 頁 - Google 圖書結果

私密轉送( Beta )開啟〉%隱藏我的電郵> 7 打開 iOS 「設定」>「 Apple ID ... 清除瀏覽記錄及資料天氣> PC 118.193.236.204/CN_wang614393 OpenVPN 翻譯>取消 PC ... 於 books.google.com.tw -

#54.我應該使用Skype Beta 版嗎?

重要事項: 此文是經由自動翻譯軟體翻譯(機器翻譯),而非人力翻譯。 詳情請參閱此文。 Skype 使用機器翻譯,提供多語言版本的說明及支援文章 ... 於 support.skype.com -

#55.Android 版Chrome 28 Beta 上線:翻譯列、平板全螢幕模式

對桌機版Chrome 的用戶來說,在訪問外文網站時可用的翻譯列功能應該是再熟悉不過了。而如今在Android 版Chrome 28 Beta 中Google 也加入了這項功能, ... 於 chinese.engadget.com -

#56.Beta是什麼意思 - IG

金融工具的beta指標用以評估該工具與更廣泛市場想比較時的風險或波動性。 於 www.ig.com -

#57.Beta的繁體中文翻譯

Beta 的翻譯結果。 於 zhcnt66.ilovetranslation.com -

#58.beta翻譯-日文翻譯|快速找到專家為您服務-PRO360達人網

關於beta翻譯- 有7212筆推薦專家供您選擇,beta翻譯相關服務有日文翻譯、韓文翻譯、法文翻譯。免費取得多位專家報價,立刻線上預約服務。生活大小事就讓PRO360為您解決 ... 於 www.pro360.com.tw -

#59.頂尖名校必修的理性談判課: 哈佛、華頓商學院、MIT指定閱讀,提高人生勝率的經典指南(Negotiating ...

譯者簡介葉妍伶英國愛丁堡大學翻譯碩士。 ... 獻給 Beta Mannix、Greg Northcraft、Leigh Thompson、 Kathleen Valley以及Sally White 你們不僅是最棒的同事, ... 於 books.google.com.tw -

#60.beta coefficient是什麼意思、英文翻譯及中文解釋 - 商務英語

beta coefficient是什麼意思、英文翻譯及中文解釋引薦:betacoefficient詞語:betacoefficient解釋:貝塔(β)係數詞典:商務專業英漢 ... 於 m.yyxkb.com -

#61.beta中文(繁體)翻譯:劍橋詞典

beta翻譯 :(希臘語字母表的第二個字母), (軟體程式)尚未推出市場,處於第二個開發階段的, 靦腆的,缺乏自信的。了解更多。 於 dictionary.cambridge.org -

#62.【中文歌詞翻譯】Taylor Swift – Betty @ 凱莫的小天地 - 痞客邦

Taylor Swift前幾天發行了新專輯整張專輯聽完馬上愛上的就是這首”Betty” 因為真的很喜歡Taylor唱這種鄉村曲風的歌從這首的開頭的口琴和吉他聲就覺得 ... 於 a0925316085.pixnet.net -

#63.大陸Omicron滅活疫苗臨床試驗啟動首針在杭州施打 - 經濟日報

中國生物在前期已上市原型株新冠滅活疫苗和完成Beta、Delta變異株滅活疫苗研發的基礎上,從香港大學引進Omicron變異毒株,2021年12月9日啟動疫苗研發 ... 於 money.udn.com -

#64.beta 的中文翻譯| 英漢字典

beta 貝它,希臘字母的第二個字母. 於 cdict.net -

#65.Komica

KOMICA · 連線板 · ☆2CAT · ☆貓管理部 · ☆站務公告 · ☆動畫 · ☆漫畫 · ☆影視 · ☆綜合 ... 於 www.komica.org -

#66.翻译'beta' - 印度尼西亚文-中文字典 - Glosbe

检查“ beta”到中文的翻译。浏览句子中beta的翻译示例,听发音并学习语法。 於 zh.glosbe.com -

#67.네이버 중국어사전

오픈사전 · 참여번역 · 오픈사전PRObetanew. 바로가기. 작은창 사전 단어장. 언어설정 한국어더보기. 한국어 简体中文. 필기입력기 문자입력기. 자동완성. 검색. 於 zh.dict.naver.com -

#68.搜尋淡江大學(Tamkang University) 影音後製人員人才履歷 ...

翻譯 人員. 工作年資. 小於1 年 4 到6 年. 預期工作模式. 全職. 進階搜尋. 期望工作地點. Taipei City, Taiwan Taiwan 台北市, 台灣 台灣. New Taipei City, Taiwan 於 www.cakeresume.com -

#69.OP.GG: LoL Stats, Record Replay, Database, Guide

will be shut down as of June 23rd due to termination of the Riot API Beta Service. Thank you for using the service and we will be sure to notify when the ... 於 tw.op.gg -

#70.軟體裡的alpha版和beta版是什麼意思?

Beta ,目前普遍認為是“測試”的意思。廣義上對測試有著三個傳統的稱呼:Alpha(α)、Beta(β)和Gamma(γ),用來標識測試的階段與範圍。 於 topic.alibabacloud.com -

#71.Customer 360 全域設定檔資料連線(Beta 版) - Salesforce Help

您位於此處:. Salesforce 說明 · 文件 · 分析. 警告. 目前版本的翻譯正在進行中。您所見內容來自先前的版本 ... 於 help.salesforce.com -

#72.Beta(β)是什麼意思?衡量投資策略超額報酬與大盤相關性的指標

Beta (β)是什麼意思?–用來衡量大盤波動的指標 ... Beta值(ß、貝他值)用來衡量系統性風險、大盤連動性,也就是指數的波動幅度, 可以於衡量股票、投資組合 ... 於 rich01.com -

#73.beta - 马来文-华文字典 - eKamus

第一代名词)朕,寡人(国王的自称) 2. 第二个希腊字母. berbeta 用"beta"这个称呼. 建议单字/纠正错误. eKamus 马来文字典. 马来文-华文字典| Kamus Melayu Cina ... 於 www.ekamus.info -

#74.Omicron高比例無症狀陳建仁:勿誇大推測疫情、造成恐慌| 生活

這些預測往往根據以往Alpha、Beta、Delta變異株的致死率(確診死亡數除以確診病例數的百分比),或是其他國家的致死率,套用在我國Omicron確診個案, ... 於 www.cna.com.tw -

#75.電子學CH4 -alpha 求出beta 公式 - YouTube

https://sites.google.com/site/jonasdigiclass/ 於 www.youtube.com -

#76.beta:Beta代表β,泛指測試的意思 - 中文百科知識

Beta 代表β,泛指測試的意思,常用於軟體命名。廣義上對測試有著三個傳統的稱呼:alpha(α)、beta(β)和gamma(γ),用來標識測試 ... 於 www.easyatm.com.tw -

#77.Beta翻譯及用法- 英漢詞典 - 漢語網

Beta 中文的意思、翻譯及用法:n. (Beta) (羅馬尼亞、波蘭、美、印度)布蕾塔(人名)n. β(希臘字母表的第二個字母);β項,β類;β等,乙等;β星;β衰變的,β粒子的 ... 於 www.chinesewords.org -

#78.beta的中文意思 - Dict.site 英漢/漢英線上英文字典

beta 中文意思是什麼. beta 解釋. n. 名詞 1. 希臘字母第二字[B,β]。 2. 第二位的東西。 3. 【天文學】β星〈星座中第二等最亮的星〉。 於 dict.site -

#79.HPX-GOV: 歡迎

歡迎來到HPX-GOV 小組 成立的GDS Digital Service Manual 中文翻譯網站(beta)。 如何開始? 英國政府數位服務設計手冊-全貌. 英國政府數位服務設計手冊 ... 於 gds.hpx.tw -

#80.MUGEN Beta 1.0 1.1版文檔翻譯(中文) - 巴哈姆特

請勿將這些翻譯檔案取代原文檔案。 5.WinMUGEN又稱為Beta版。 不會包含1.0和1.1新增的代碼文檔翻譯。 於 forum.gamer.com.tw -

#81.[翻譯]Long War Beta 15b - steam | PTT遊戲區

這是翻譯沒翻完求神人BETA 15 to BETA 15b Issues ‧ If you are well into a campaign and have researched advanced Medikits, all of your soldiers ... 於 pttgame.com -

#82.Beta是什么意思? Beta翻译(中文英文) - 抓鸟

Beta 的解释是:测试第二版在软件领域,“bet… 同时,该页为英语学习者提供:Beta的中文翻译、英英详解、单词音标、在线发音、例句等。 於 dict.zhuaniao.com -

#83.已解决- 求weave v2 beta翻译 - 贞德论坛

求贞德波波联手出一个weave v2 beta的翻译,求求求. ... 本论坛全套翻译教程系列请查阅:https://hvhbbs.com/threads/3889/ 社区对转社区服务器请 ... 於 hvhbbs.com -

#84.beta在线翻译- 英语_读音_用法_例句 - 海词词典

海词词典,最权威的学习词典,为您提供beta的在线翻译,beta是什么意思,beta的真人发音,权威用法和精选例句等。 於 dict.cn -

#85.Subtitle Edit online BETA 免費線上翻譯字幕工具 - 電腦王阿達

... 可能發生到找不到的情形,這時就能透過這款Subtitle Edit online BETA 線上翻譯字幕工具,把國外字幕一鍵翻成繁體中文,完全免費且支援超多語言。 於 www.kocpc.com.tw -

#86.Safari 翻譯怎麼用?教你2 招將iPhone 網頁翻為中文或其他語言

相信大家都會覺得Safari 網頁翻譯功能還有很大的進步空間,但目前這功能還算是Beta 版,所以我們只能期待Apple 逐漸加強這部分,讓所有的用戶能盡快 ... 於 www.tech-girlz.com -

#87.beta-翻译为中文-例句英语

使用Reverso Context: beta-hch, beta version, beta-carotene, alpha and beta, alpha- and beta-hch,在英语-中文情境中翻译"beta" 於 context.reverso.net -

#88.Beta adrenergic receptor blocker 腎上腺素能受體阻滯劑

Beta adrenergic receptor blocker 腎上腺素能受體阻滯劑,是什麽意思,英文怎麽說,中文意思,心血管係統醫學名詞-詞匯翻譯,美國LetPub 論文編輯. 於 www.letpub.tw -

#89.艾欧泽亚NGA玩家社区NGA玩家社区

4 创作者激励活动·第一期 + ▼ Yuichiro04‑05 18:52 ▼ 04‑24 07:28愿夜无云 3 没想到真的能碰上“休闲玩家” + • umiiirei20分钟前 10分钟前theaho 1 想问问雷马是在湖区刷吗 • 酸奶炒粉30分钟前 30分钟前白纸sama 4 首周梦碎的野队人 • ABEK40分钟前 25分钟前ABEK 於 bbs.nga.cn -

#90.單字beta的中文意思與發音 - Websaru線上字典

beta 中文意思: beta [bi:tә; (-) 'beitә] n.貝它,希臘字母中的第二個字母..., 學習beta發音, beta例句盡在WebSaru字典。 於 tw.websaru.info -

#91.Thunderbird Beta - Mozilla Support

若您想了解如何翻譯SUMO 文章,請從此處開始。 Beta is a test and development channel where users of beta get fixes and feature changes before they are made ... 於 support.mozilla.org -

#92.Diablo Immortal 暗黑破壞神永生不朽正式公開上市日6大必玩理由

亞太區較遲上市的原因是準備繁體中文翻譯以及架設亞太區專用伺服器需要額外 ... 版的開發較遲,所以在手機版正式推出之時,PC版將會以beta形式推出。 於 www.hk01.com -

#93.翻譯選取文字

翻譯 選擇的文本與谷歌翻譯. ... Beta version** As this extension has so many users I've decided to upload a Beta version of the extension to ... 於 chrome.google.com -

#94.iPhone Safari 網頁翻譯功能使用教學:不懂英文也沒關係

打開你要瀏覽的外文頁面後(我以英文為例),點擊網址列左側的“大小”: · 就能看到“翻譯成簡體中文” 的功能。 · 首次使用會跳出目前還處於Beta 測試階段的 ... 於 www.rockyhsu.com -

#95.SOGI手機王- 提供手機價格,手機推薦與比較服務

SOGI手機王為全國最大手機、平板電腦資訊與行動通訊社群網站,提供智慧型手機、平板電腦、穿戴裝置等規格介紹、產品比價及評測報告、電信資費、軟體教學、配件與討論. 於 www.sogi.com.tw